Ich kaufe immer die leistungsfähigsten Notebooks, die gerade zu bekommen sind – und nutze sie dann jahrelang. Ich könnte mich mit einer vorbildlichen Nachhaltigkeit rühmen, aber tatsächlich ist mir der Austausch der Hardware immer eine Qual, ich nutze die Systeme also immer so lange, bis das aktuelle Windows signifikant langsam wird. Auch bei der Windows-Version bin ich eher konservativ, Stand heute (3.4.2023) sind alle Systeme auf dem neuesten Windows-10-Stand, Windows 11 ist bisher nur auf einem Testsystem im Einsatz.

Trotzdem fallen mit der Zeit immer wieder Notebooks an, die für das wuchernde Windows nicht mehr geeignet sind. Da die Rechner aber technisch noch nicht reif für die Verwertung sind, stellt sich die Frage, was man mit ihnen anfangen könnte.

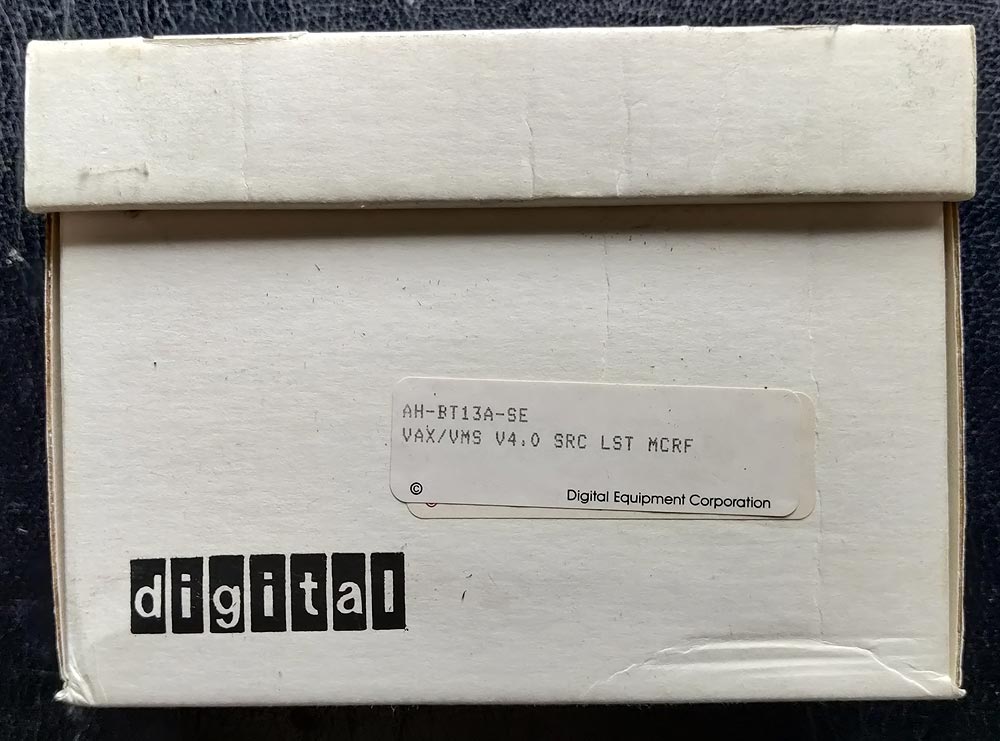

Da kommt dann sehr schnell Linux ins Spiel. Da alle Server entweder unter OpenVMS 8.4 (auf den Digital Alpha DS15) oder als ESX-Clients mit Debian 12 auf IBM-/Lenovo-Server laufen, war die Wahl des Linux-Derivats klar. Zugleich bot es sich an, es auch gleich mit freien Alternativen zu den inzwischen doch recht teuer gewordenen Produkten wie Office 365 oder der Adobe-Suite zu versuchen.

Als Basis für den Versuch habe das alte Notebook meiner Frau, ausgestattet mit einem AMD-E-450Prozessor, 6GB Hauptspeicher , HDI- und VGA-Ausgang, 3 USB-2.0-Anschlüssen, Ethernet, WLAN und einer 240GB SSD,die wir schon zu Windows-Zeiten zur Leistungsverbesserungen eingebaut hatten. Der Bildschirm löst 1366×768 auf. Insgesamt also für seine Zeit eher ein gut ausgestattetes System, das allerdings unter Windows 10 schon erschreckend langsam lief.

Die Debian-Installation ist einfach, besonders, wenn man ohnehin schon einige Systeme in Betrieb und daher auch Erfahrung hat. Alle Hardwarekomponenten, die Grafikkarte, die Bildschirmauflösung werden einwandfrei erkannt, die Netzwerkverbindung sowohl über den Ethernet-Port wie auch über WLAN zuverlässig aufgebaut.

Als Software-Komponenten habe ich installiert:

- Libreoffice als Ersatz für Microsoft Office

- GIMP als Ersatz für Adobe Photoshop

- Scribus statt Adobe Indesign

- Darktable statt Adobe Lightroom

- Freeplane ersetzt Mindmap

- Draw.Io statt MS Visio.

- Blender als Ersatz für Adobe Premiere (wobei Blender eigentlich eher Maja ersetzt)

Weitere Software-Pakete aus der Welt der freien Verfügbarkeiten:

- Skype

- Thunderbird als Email-Client

- Keepath

- Nextcloud-Client zum Zugriff auf meine eigene Cloud

- Audacity für die Digitalisierung von Audioquellen

- Filezilla für den FTP-Zugriff auf die OpenVMS-Server

Dazu meine persönlichen Präferenzen:

- Emacs als leistungsfähiger Editor

- Remmina für den Fernzugriff auf Xrdp-Systeme (Remote Desktop)

Das einzige Kaufprodukt, das installiert ist, ist NordVPN.

Fazit:

Das installierte System ist mit allen Zusatz-Softwarepaketen immer noch deutlich schlanker als ein Windows nach der Erstinstallation, und es startet deutlich schneller.

Die Ersatz-Software, bietet für mich die gleiche Funktionalität wie die Kaufprodukte (wobei ich sicher beide nicht bis aufs Letzte ausreize). Allerdings erfordert der Umstieg einiges an Eingewöhnung, da Funktionen oft anders benannt sind, anders parametrisiert werden und sich in anderen Menüs verstecken. Nach einer gewissen Eingewöhnungszeit sollte das aber kein Problem mehr darstellen.

Alle Daten ließen sich problemlos im- und exportieren, ein Austausch mit Microsoft-Nutzers z.B. war mit den Dateien, die ich so produziert habe, kein Problem. Als erweiterten Test habe ich diese Produkte auch sowohl auf einem Windows-Testsystem als auch auf einem Mac Mini installiert, auch da gab es keine Probleme, damit kann man also ohne Lizenzprobleme saubere nutzbare Systeme auf beiden Plattformen aufbauen.

Da alle Softwarepakete schnell starten und sehr gut reagieren, hat man selbst bei einer heute nicht mehr aktuellen Prozessorleistung mit einer Linux-Basis ein nutzbares System.

Was fehlt?

Online-Banking geht fast immer nur über den Browser, die Banking-Software, die ich einsetze, ist nur für Windows verfügbar.

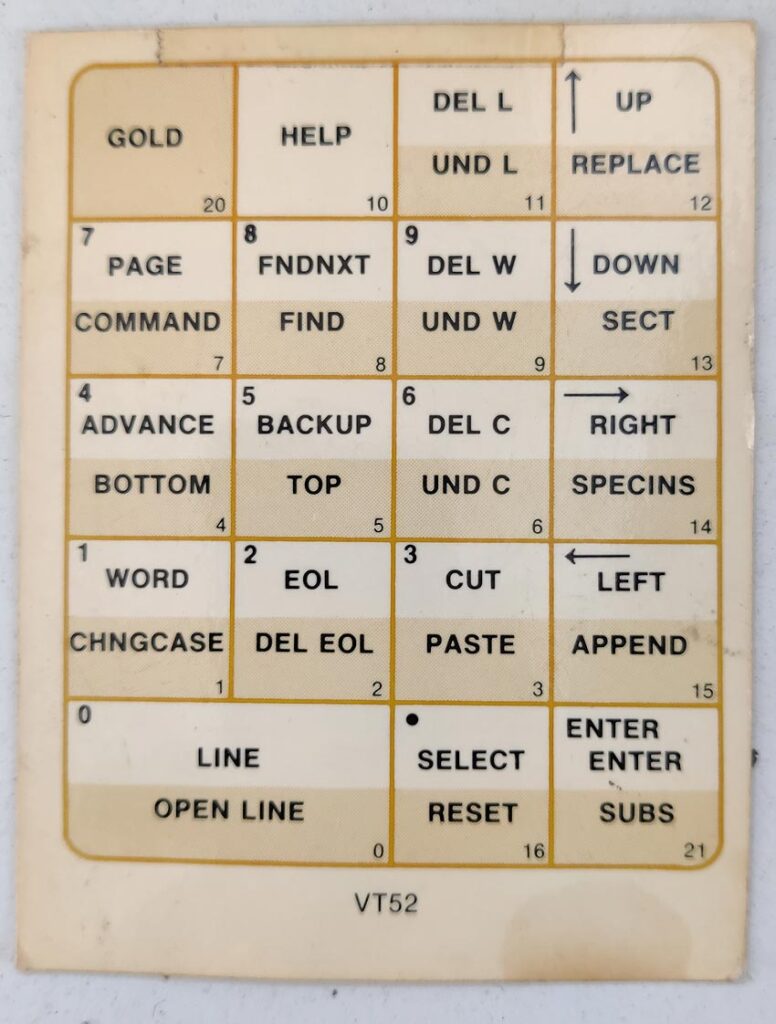

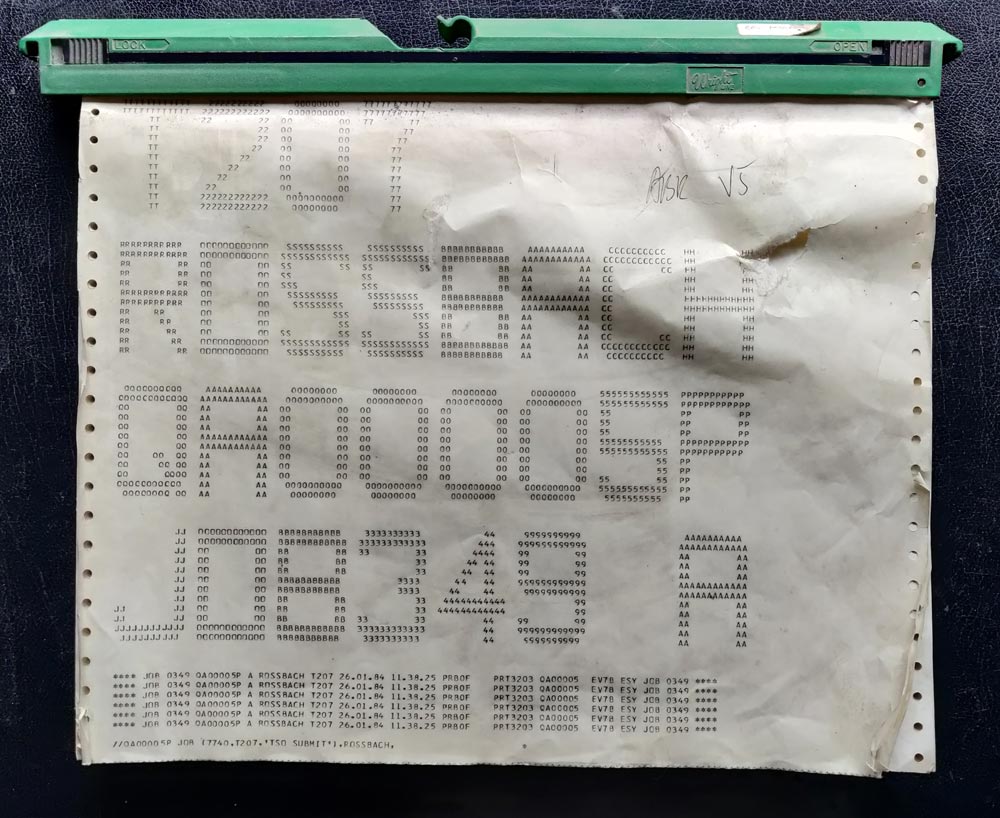

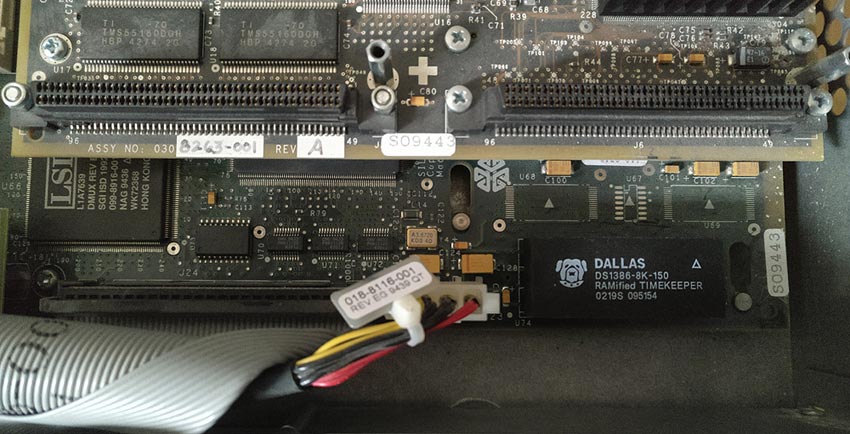

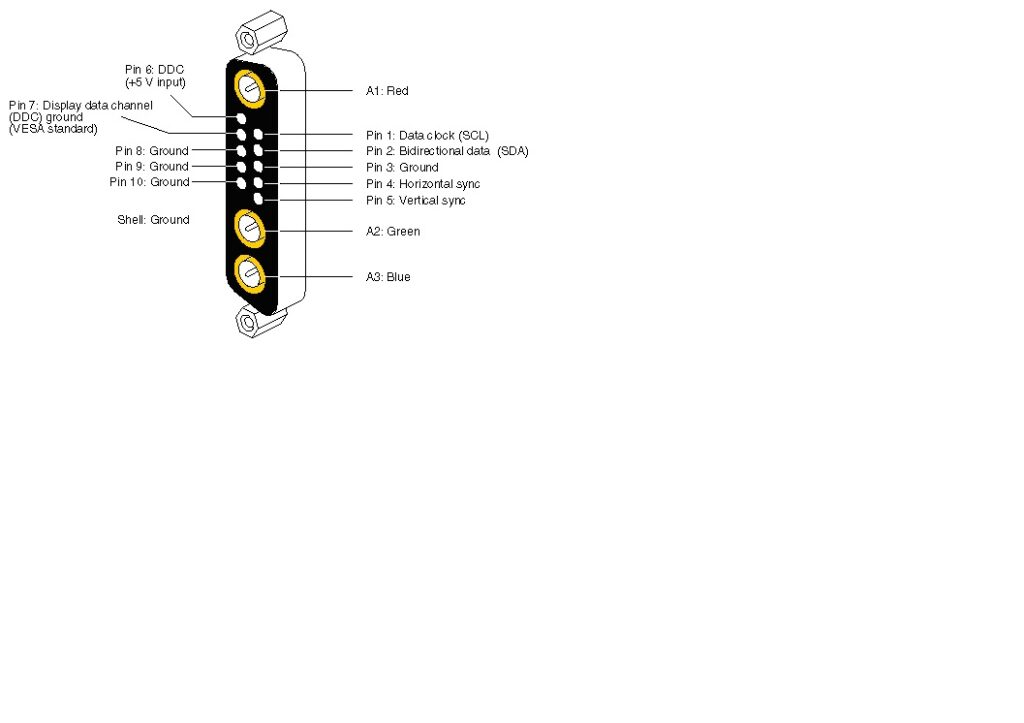

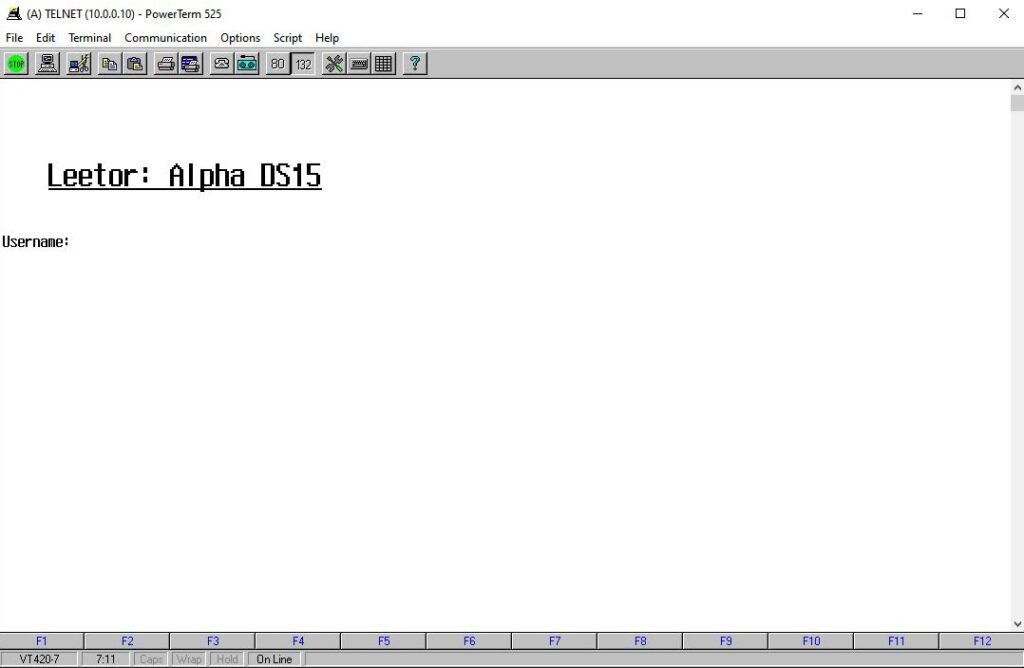

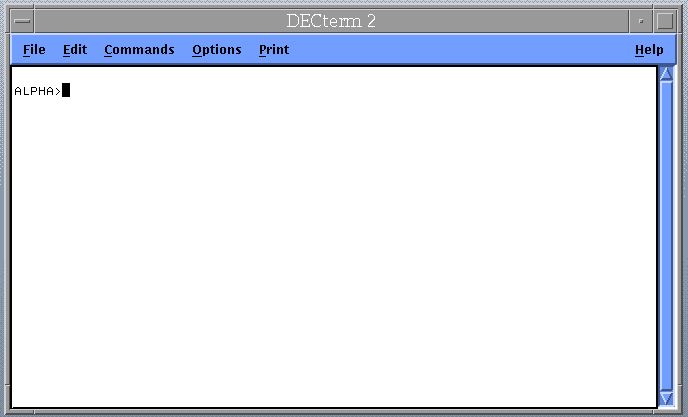

Digital Pathworks! Die meisten werden das Produkt nicht kennen, für mich als alten OpenVMS-Administrator, -Entwickler und -Nutzer ist es wichtig, da es diverse DEC-kompatible Terminals bereitstellt. Das in jedem Linux vorhandene Xterm kann nur ein VT100 emulieren, das reicht für eine vernünftige Arbeit auf den Alphas nicht aus. Aber ich muss zugeben, das ist ein Minderheitenproblem, das sich für 99% aller Notebook-Nutzer nicht stellt. Ich dagegen habe noch einen Kunden im Ausland, der immer wieder einmal etwas Expertenwissen benötigt. So hätte ich es gerne:

Debian selbst, und alle dort integrierten Produkte, hat einen langsamen Aktualisierungszyklus, nicht immer steht die letzte Version der Anwendungssoftware zur Verfügung. Dafür allerdings ist die Plattform gut getestet und sicherheitsrelevante Updates werden schnell bereitgestellt.

Eine Spielerei:

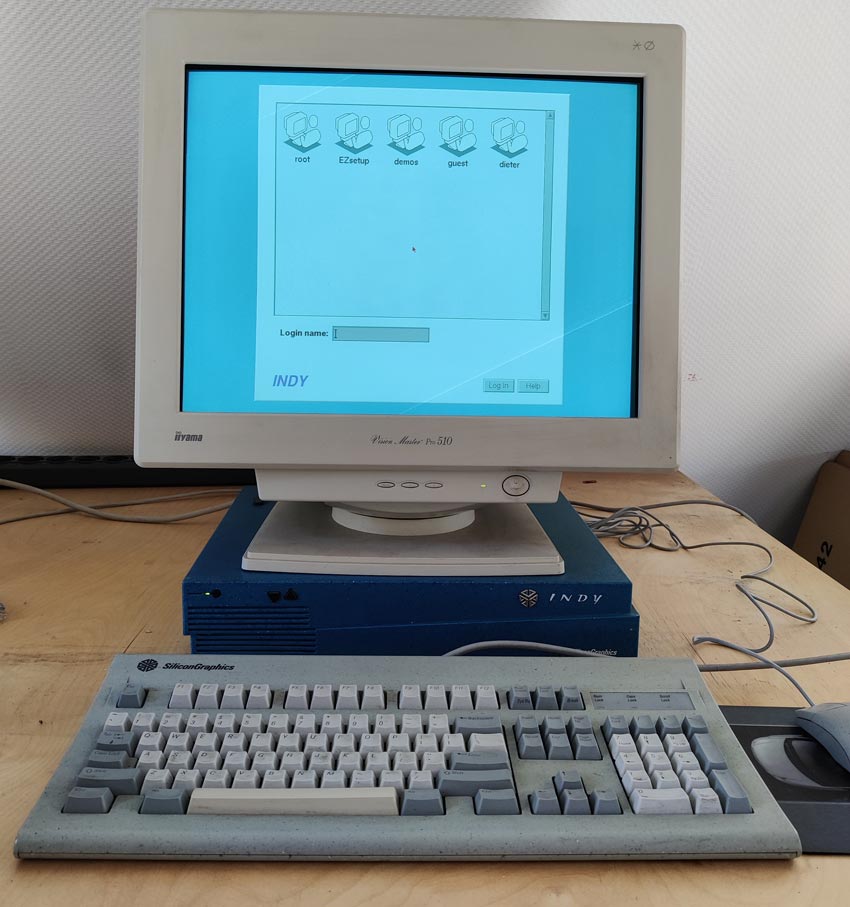

Das Projekt MaXX Desktop bringt die Oberfläche der IRIX-Systeme von Silicon Graphics auf das Notebook. Diese Bedienoberfläche war einmal das modernste, was der Workstation-Markt in den achtziger Jahren bot. Wer also nostalgisch an die Zeit zurückdenkt, kann sein System entsprechen gestalten. Tatsächlich ist es auch besser, als altes SIG-Systeme zu reaktivieren, das es auf der neuen Hardware natürlich um Klassen schneller arbeitet und man Zugriff auf aktuelle Werkzeuge erhält, die es in den Achtziger noch nicht gab und die auch nie portiert wurden.